从8月1号开始合约建仓到今天下午平仓,1800 USDT 滚成了 6055 USDT,年化收益率1000% 左右,难能可贵的是上百次交易没有一单是亏损的。当然也几乎次次都没有踩到完美节奏,有必要总结一下经验与教训。

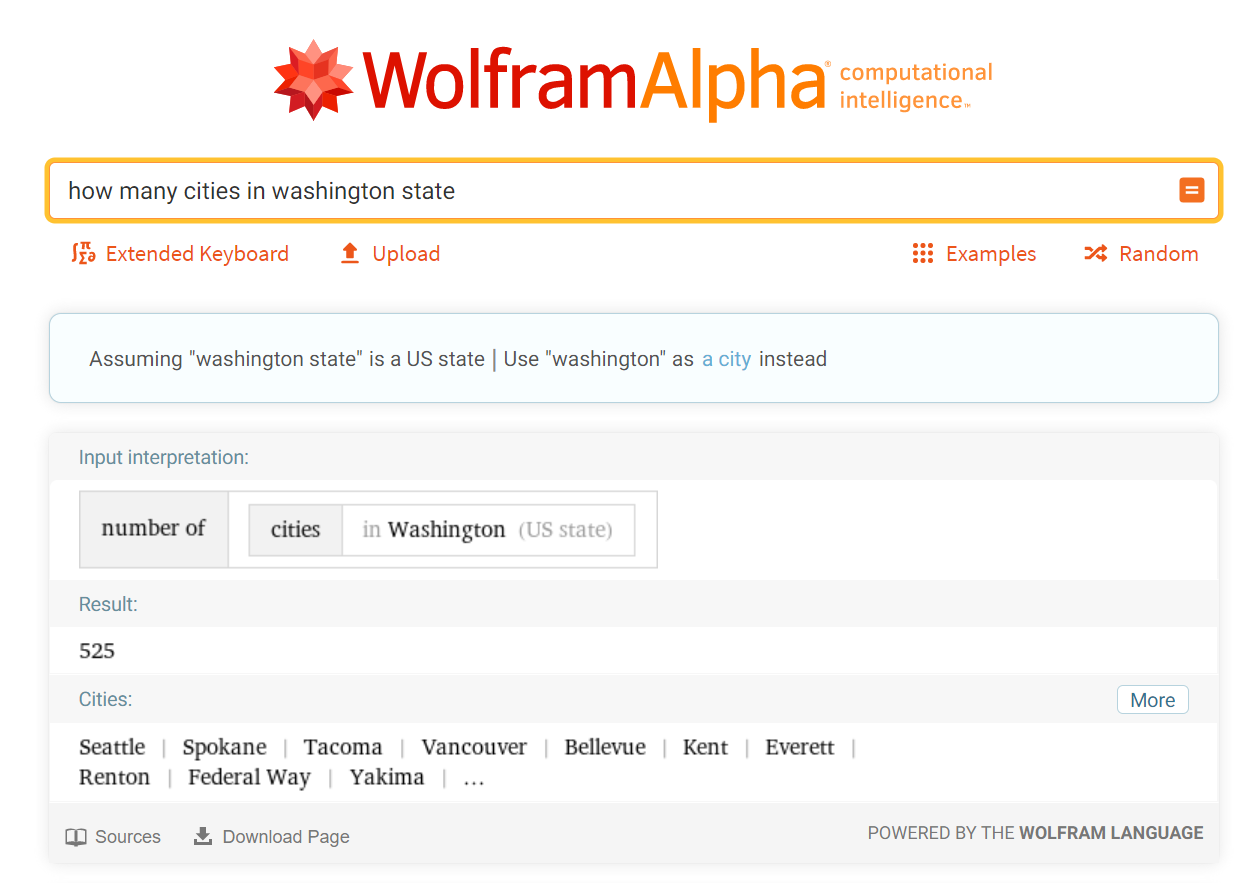

什么是加密货币

参考维基,我并不懂,大概理解是用加密算法保证了稀有程度的货币,代表是最早的比特币,后来根据类似的原理设计出了很多种不同类型的加密货币,比较著名的有

等等。

怎么交易加密货币

交易加密货币类似于炒外汇,因为有很多不同类型的加密货币,交易就是不同币种之间的兑换,但是怎么跟法币兑换呢?最常见的办法是有一类加密货币叫稳定币,价格锚定美元或者别的法币,比如常见的 USDT, USDC 等等,实际操作时我习惯先用法币购买 USDT, 然后用 USDT 交易,因为 USDT 本身也是加密货币是可以方便的在各个交易所-个人钱包之间转账的。几家大的交易所包括

什么是永续合约

这里有详细的讲解。需要记住的是这是一种永不到期的期货,使用资金费率来保证合约价格锚定现货价格,可以方便的加杠杆来做多或者做空。

为什么选择交易加密货币永续合约

我这里跟美股做一下对比

- 加密货币价格波动很快,一天的上下波动可以对比一个月的股票价格波动,相当于资金利用率大大提高

- 因为是期货所以做空很方便,不会出现借不到现货的情况

- 杠杠不需要付昂贵的利息,在多空双方实力一致的理想情况下,资金费率的期望应该是0,也就是没有额外的借款成本,交易量比较大的币种实际上就是趋近于0的

- 市场还是不够成熟,追涨杀跌非常常见,对手盘交易模式有规律可循

我的交易策略

因为我极度厌恶风险,所以操作上是优化本金不失而不是追求更高利润。上面说过价格波动模式很有规律,在最近的时段上看类似于一个正弦曲线,当然价格围绕价值变动也是很合理的,同时,我们能看到这个波动偶尔会陡然升高,然后再次回归价值,抓住大的波动就是这个策略的关键,我把他叫做钓鱼,三步走

- 选择一个小规模的币种监控列表,这里我会剔除所有的新币,因为不知道他们会稳定在什么价格附近

- 监控价格大规模起伏,不同币种不同时间阈值不一样,例如 10% - 20%,反方向下单

- 最关键的是这一步,方向反转之后,有盈利就撤,我是只赚 2%

实际操作中会碰到很多细节的问题,例如杠杠倍数选择,推荐从4倍开始练手,不推荐超过5倍。如果趋势没有当场发生发转,需要持续补仓,推荐任何时刻不要超过半仓以防不测

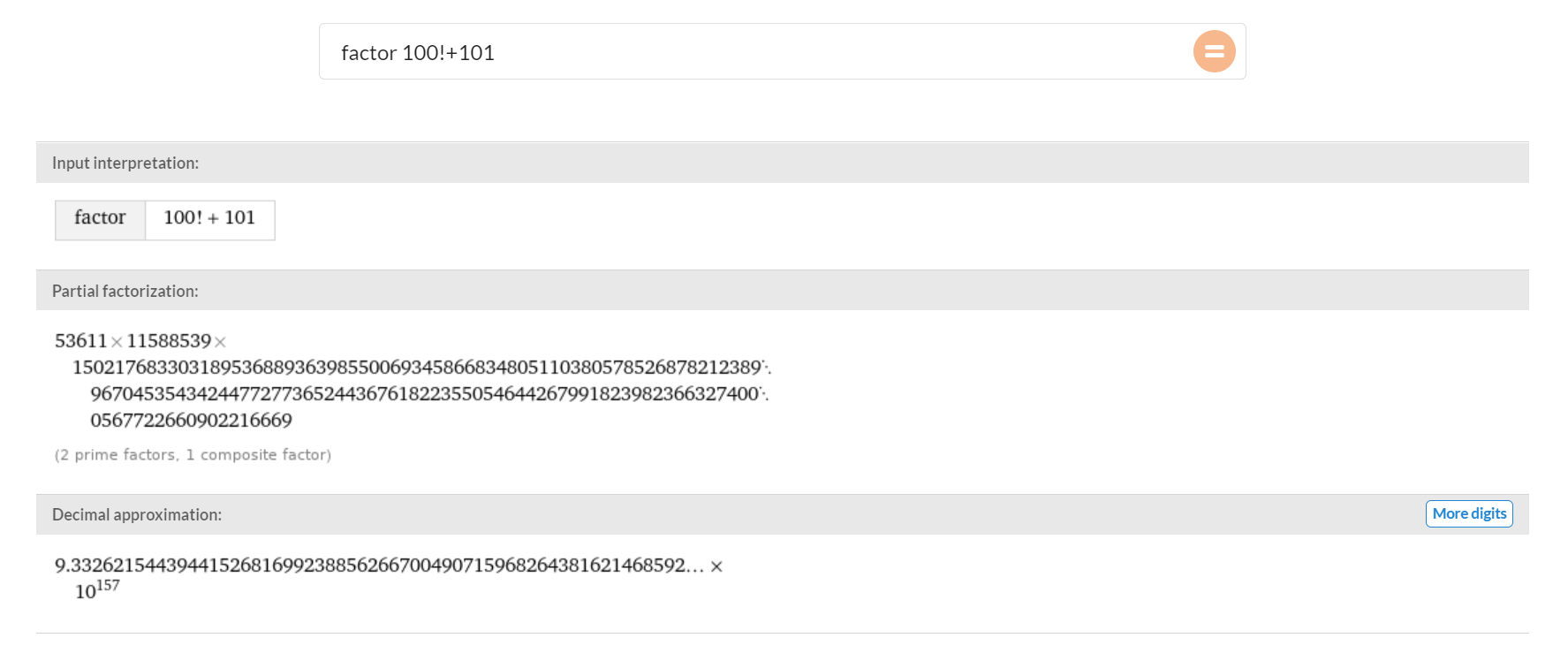

为什么不用套利策略?

有人会说如果厌恶风险那为什么不采用套利策略呢?最开始研究过期现套利,写了模拟程序跑了一下,两个问题

- 抓到的基差很小导致去除4次手续费后几乎无利可图,可能是因为套利的机器人太多了稀释了利润

- 期现套利需要短时间两边下单,但是没法保证两单一定能成功,这就需要复杂的机制来进行事故处理,例如主动滑点吃单等,进一步压缩利润里

另外我有个朋友的期现套利实盘因为种种原因暂停了更坚定了我的想法

单边行情怎么办

事实上第三步就是为了防止市场单边行情,有盈利就空仓,实际上从没碰到过每个小时线都是持续上涨没有任何回调的行情。合理的仓位管理是能保证平摊成本在最坏情况下一定离定点不远,等待回调,不要用太高的杠杆也是为了出现最差情况后不会被强行平仓。